Нужно было сделать фото для документа. Собрался было ползти в фотоателье, а потом подумал - так ИИ-то на что?

Щелкнул себя на фоне стены, старался, чтобы фото получилось максимально неряшливое - пусть ИИ украшает.

Промпт сделал такой: "Обрежь эту фотографию и сделай из нее мое фото на испанский паспорт, отвечающее всем соответствующим требованиям. Белый фон, костюм с галстуком, анфас".

Вариант от ChatGPT. Терпимо.

Вариант от Gemini. Заметно лучше.

Вариант от Perplexity понравился больше всех.

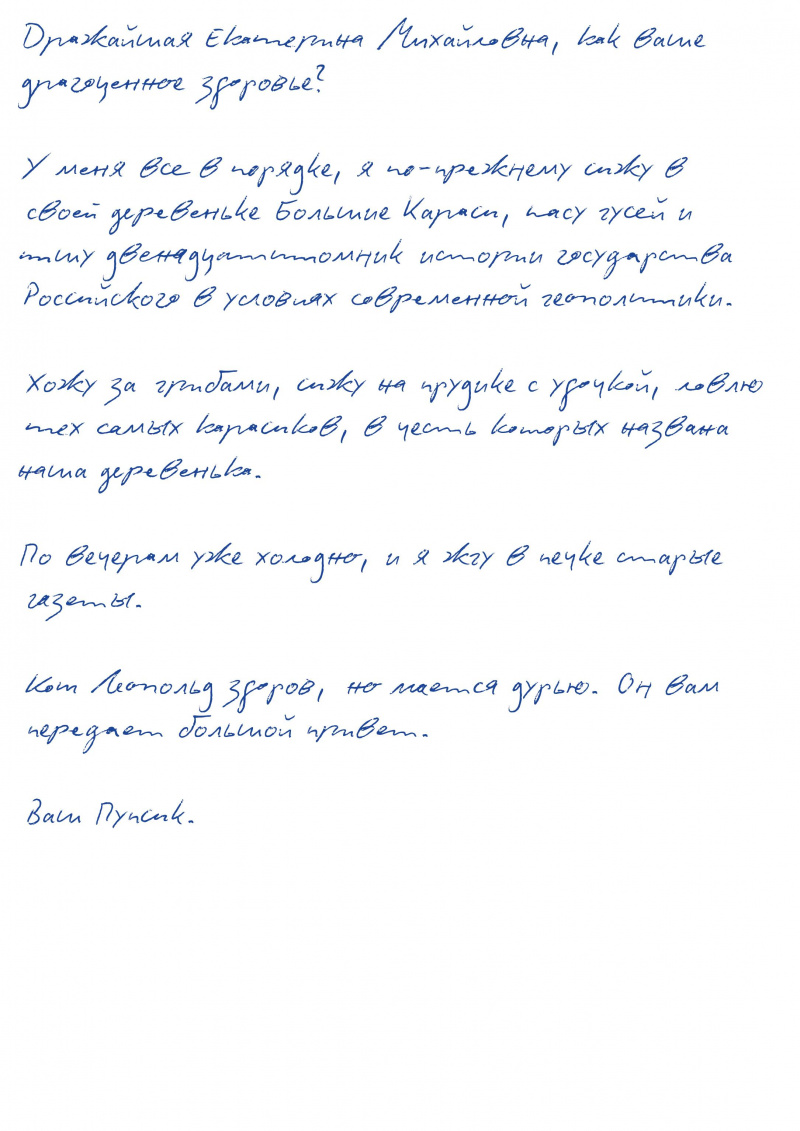

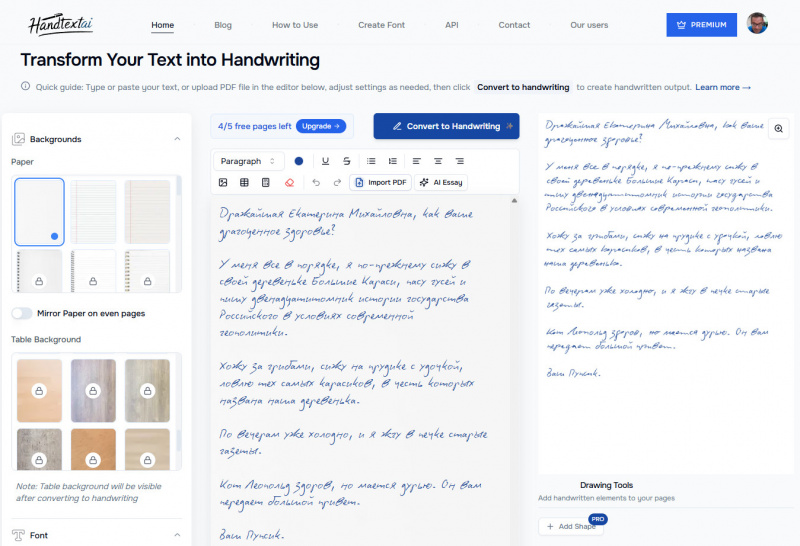

Нейронка, превращающая компьютерный текст в рукописный с высокой достоверностью. Причем там все еще и гибко настраивается - можно подобрать настройки под свой собственный почерк. Текст можно скопировать в соответствующее окно, также можно загрузить PDF. Если в тексте есть всякие таблицы, то они тоже адаптируются под рукописный текст.

Вот это я там набрал. Ну, чисто рукописный текст, не так ли? Правда, под свой почерки я настройки не подбирал, мой почерк вообще очень сложно подделать, он ужасный.

Вот это я там набрал. Ну, чисто рукописный текст, не так ли? Правда, под свой почерки я настройки не подбирал, мой почерк вообще очень сложно подделать, он ужасный.

Бесплатно дают сконвертировать до пяти страниц, дальше надо платить. Также всякие тонкие настройки доступны только в Premium версии ($6-8 в месяц, в зависимости от того, платите за год или помесячно).

Ну и вот маленький ролик о том, какие возможности там предоставляются.

Кажется, старая хохма еще со времен Фидо о том, что "думаешь, что общаешься с юной прелестницей, а это оказывается бородатый программер с пузом сорока пяти лет" с развитием нейросетей получает совершенно новое воплощение.

Новый генератор видео Google VEO 3.1.

Умеет работать с опорными кадрами - загружаете фото, он его использует в видео. Запросы на русском тоже понимает.

Вот пример промпта: "Милый пушистый котик сидит в кресле, курит сигару, попивает красное вино из бокала и смотрит телевизор, в котором показывают танцующих кошечек".

С сигарой, конечно, получилось несколько неудачно, мы с Бубликом теперь переживаем за котика, но в общем и целом - качество впечатляет.

Вот еще промпт: "Миловидная миниатюрная брюнетка огромным топором рубит дрова, а рядом сидит атлетически сложенный мужчина, который попивает пиво из бутылки".

Залог успеха при работе с ИИ - правильно составленный промпт.

Компания OpenAI опубликовала набор эффективных промптов (на английском), разбитых по соответствующим категориям: рабочие промпты, маркетинг, IT, для менеджеров, для сотрудничества, для продуктивности, для инженеров - и так далее, и тому подобное.

Например:

Написать профессиональный e-mail.

Напиши профессиональное электронное письмо [адресату]. Письмо касается [темы] и должно быть вежливым, четким и лаконичным. Укажи тему письма и краткую заключительную фразу.

Адаптировать сообщение для аудитории

Переформулируйте это сообщение для [тип аудитории: руководители, коллеги или клиенты]. Сообщение было первоначально написано для [контекст]. Отредактируйте тон, выбор слов и стиль в соответствии с целевой аудиторией. Текст: [вставьте текст].

Резюме для цепочки писем

Сделай краткое резюме этой цепочки писем. Цепочка включает в себя несколько писем, отправленных в обоих направлениях. Выдели ключевые решения, действия и открытые вопросы. Электронное письмо: [вставьте текст].

Компания OpenAI представила новую модель генерации видео Sora2.

Sora 2, утверждают разработчики, может делать то, что было исключительно сложно (а в некоторых случаях и вовсе невозможно) для моделей предыдущего поколения видео: олимпийские гимнастические упражнения, сальто назад на доске для гребли, точно моделирующие динамику плавучести и жёсткости, тройные аксели фигуристки, когда кошка изо всех сил держится у нее на голове.

Sora 2 это все умеет делать.

Предыдущие видеомодели трансформировали объекты и искажали реальность, чтобы успешно выполнить текстовую подсказку. Например, если баскетболист промахивается, мяч может спонтанно телепортироваться в кольцо. В Sora 2, если баскетболист промахивается, мяч отскакивает от щита.

Модель также представляет собой большой шаг вперёд в плане управляемости, способная следовать сложным инструкциям, охватывающим несколько кадров, точно сохраняя состояние мира. Она превосходно подходит для реалистичного, кинематографичного и аниме-стилей.

Sora 2 также позволяет напрямую внедрять элементы реального мира. Вот примеры реальных видео, встроенных в созданную Sora среду.

Первоначально эта модель будет доступна на соответствующем сайте в США и Канаде, позже доступ дадут и в других странах. Для платных пользователей ChatGPT будет доступна улучшенная модель Sora 2 Pro.

Ну как? По-моему, впечатляет!

В комментариях к обсуждению подписки на Perplexity AI высказали предположение, что этот сервис может хранить вашу переписку с различными моделями AI. Насколько я знаю, практически все AI хранят эту переписку и могут отправлять на проверку то, что они считают опасным.

Но я задал вопрос ChatGPT по поводу того, какие опасности могут быть при использовании Perplexity AI.

Потом задал данный вопрос в самой Perplexity AI. Получил ответ, очень мало отличающийся от ответа ChatGPT. Кстати, если спросить об опасностях при использовании ChatGPT, то ответ будет очень похожим, и его тоже привожу ниже.

Использование Perplexity AI связано с определёнными рисками для безопасности и конфиденциальности, которые неоднократно отмечались экспертами и в СМИ по состоянию на сентябрь 2025 года.gerki+5

Основные угрозы безопасности

Уязвимости приложений

В Android-версии Perplexity AI найден ряд серьёзных уязвимостей: открытые ключи API, отсутствие базовой SSL-фиксации (защиты трафика), возможность межсайтовых атак и небезопасная организация интерфейса API позволяют атакующим похищать учётные данные и персональные сведения, а также создавать поддельные версии приложения.uscsinstitute+1Отсутствие сквозного шифрования

Данные пользователя (вопросы, история поиска, IP-адреса, информация об устройстве) собираются для улучшения моделей, но компания не реализует по умолчанию сквозное шифрование, что повышает риски утечки данных или их перехвата третьими лицами.pcmatic+2Новая браузерная версия и поведенческий трекинг

В 2025 году Perplexity представила браузер с ИИ, интегрирующий сбор данных по всему интернет-серфингу пользователя, что делает платформу частью новой волны «surveillance capitalism» — экономики наблюдения. Такой браузер отслеживает каждую вкладку и клик пользователя.secureitworld+1Проблемы конфиденциальности

Хранение личных данных и их использование

Компания имеет не очень прозрачную политику хранения и использования пользовательских данных, что вызывает обеспокоенность по поводу возможного доступа государственных и частных организаций к содержанию переписки и запросов пользователей.industrywired+1Риски, связанные с загрузкой файлов

Не рекомендуется загружать в Perplexity конфиденциальные документы и изображения: обработка происходит на внешних серверах с потенциальной возможностью утечки или доступа третьих лиц.reddit+1Риск атак через внедрение вредоносных инструкций

Известен класс уязвимостей типа prompt injection, когда злоумышленник может заставить ИИ-платформу выполнить несанкционированные действия или раскрыть приватную информацию.secureitworld+1Рекомендации по безопасности

Не вводить в Perplexity AI личную, конфиденциальную или финансовую информацию.internetmatters+1

Не загружать чувствительные файлы и изображения.reddit+1

Использовать VPN и максимально ограничивать права доступа приложения.pcmatic

Следить за обновлениями приложений и не использовать альтернативные версии вне официальных источников.gerki+1

Вывод

Perplexity AI полезен и функционален, но в ряде реализаций и сценариев применения по состоянию на 2025 год содержит критические недостатки в защите данных и может подвергать пользователей риску утечки приватной информации, кражи учётных данных и мониторинга действий в Интернете.

А теперь об опасностях при использовании ChatGPT.

Использование ChatGPT (https://chatgpt.com/) в целом считается безопасным, но связано с некоторыми рисками для безопасности и приватности, о которых важно знать пользователям.kaspersky+6

Основные риски безопасности

Передача и хранение личных данных

Вся введенная информация (вопросы, файлы) и технические данные (IP-адрес, устройство) сохраняются на серверах OpenAI и могут использоваться для обучения моделей или внутренней аналитики, а также передаваться субподрядчикам и по запросу государственных органов.privateinternetaccess+3Утечки и хищение данных

Если в сервис случайно введены конфиденциальные сведения (например, логины, пароли, коммерческая тайна), они могут быть похищены злоумышленниками в случае взлома, утечки или неправильной настройки безопасности на стороне OpenAI. В 2023 году был зарегистрирован инцидент, когда произошла утечка заголовков чатов и информации о платеже у части пользователей.lifelock.norton+1youtubeФишинг и социальная инженерия

Модель может быть использована для генерации весьма убедительных фишинговых писем и сообщений, облегчая работу киберпреступников.malwarebytes+1Использование для разработки вредоносных программ

ChatGPT способен помочь злоумышленникам в написании вредоносного кода, что отмечено в ряде исследований.malwarebytesРаспространение дезинформации

Сервис может непреднамеренно генерировать ложные факты или недостоверную информацию, на основании которой принимаются ошибочные решения.layerxsecurity+1Меры, предпринимаемые OpenAI

Протоколы шифрования для защиты данных при передаче и хранении.surfshark+1

Регулярные аудиты и программы поиска уязвимостей.security+1

Контроль доступа, многоуровневая аутентификация и фильтрация контента.layerxsecurity+1

Соответствие требованиям GDPR и других международных норм по защите данных.surfshark+1

Рекомендации по безопасному использованию

Не вводить в ChatGPT личную, финансовую или конфиденциальную информацию.keepersecurity+2

Использовать разные пароли для разных сервисов и включить двухфакторную аутентификацию.

Отключать функции памяти профиля, если не требуется сохранение контекста между сессиями.privateinternetaccess

Следить за обновлениями и быть внимательными к ссылкам, полученным через AI.

Вывод

ChatGPT оснащен современными средствами защиты, однако не гарантирует полной приватности, и существует риск утечки или некорректного использования личных данных, как и у любого крупного облачного сервиса. Важно относиться к чату как к открытому онлайн-ресурсу и избегать обсуждения тем, которые могут наносить ущерб безопасности личности или бизнеса.nordpass+6

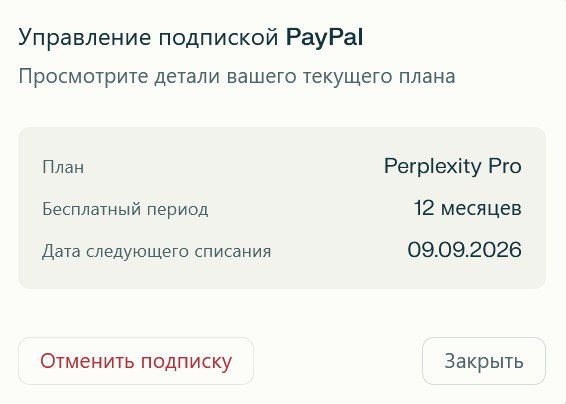

Не шутка и без какого-то подвоха, я сам это все проверил. Вам только нужно иметь PayPal.

После этого заходите сюда. Нажимаете кнопку "Получите 12 месяцев Perplexity Pro", вводите свои данные PayPal.

Ну и все, вы бесплатно получаете годовую подписку Perplexity Pro, в которую входят все вот эти модели.

Более того, отменить подписку можно в любой момент. Но я проверю, как это все работает, и если что - так и буду с PayPal платить. Я сейчас оплачиваю ChatGPT и плачу 21 евро, а тут можно за 20 евро в месяц иметь восемь платных моделей.

В Uber работают над своим ИИ, и они придумали задействовать 1,4 миллиона водителей Uber в Индии в качестве рабочей силы для своего нового проекта маркировки данных для искусственного интеллекта.

В десятке городов, включая такие крупные рынки, как Дели, Мумбаи, Хайдарабад и Бангалор, а также в более мелких городах водители теперь могут заработать дополнительные деньги, выполняя микрозадачи в приложении Uber, например, маркируя объекты на фотографиях для платформы маркировки данных компании Uber AI Solutions.

Uber AI Solutions сотрудничает с клиентами в таких отраслях, как генеративный искусственный интеллект, автономные транспортные средства, технологии и стартапы, предоставляя услуги по маркировке данных. Среди ее клиентов — компания Niantic, занимающаяся разработкой игр и искусственным интеллектом, а также производитель автономных транспортных средств Aurora.

Маркировка данных — это процесс добавления значимых тегов или описаний к необработанным данным, таким как изображения, текст или аудио, которые машины могут понимать, и на которых они могут учиться. Например, если есть база из многих тысяч фотографий автомобилей, велосипедов и пешеходов, маркировка означает обозначение того, какой объект является каким. Эти маркированные данные используются для обучения моделей искусственного интеллекта, чтобы они могли делать точные прогнозы в реальном мире, например, идентифицировать знак остановки на дороге или понять запрос клиента в приложении.

Uber запустил свой сервис маркировки данных в конце прошлого года, и сейчас над этим работа идет полным ходом.

Также известно, что Meta приобрела одну из крупнейших платформ маркировки данных в мире Scale AI за 14,3 миллиарда долларов. После чего, кстати, OpenAI и Google разорвали отношения со Scale AI, и теперь они сотрудничают с Surge AI, которая для них обучает крупномасштабные модели.

А что, для водителей это интересная возможность, ведь у них бывают всякие простои: запускаешь приложение, маркируешь данные, капает какая-то денежка.

Где-то в русскоязычных соцсетях попалось утверждение о том, что Uber будет платить водителям за это $200 в час, что полный бред, потому что индийские таксисты в месяц зарабатывают порядка 200 долларов. Но и даже если речь о 200 рупий в час - где-то 2,2 доллара, - то это все равно звучит бредом.

В англоязычных источниках утверждается, что в Uber не раскрыли, сколько они за это будут платить. Наверняка оплата будет сдельная: сколько промаркировал, столько и получил.

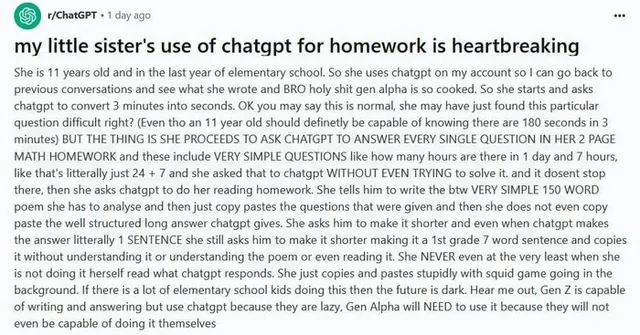

Пользователь Reddit написал пост о том, как его 11-летняя сестра использует ChatGPT. Выглядит это несколько удручающе.

«Ей 11 лет, и она учится в последнем классе начальной школы. Она использует chatgpt на моей учетной записи, поэтому я могу вернуться к предыдущим разговорам и посмотреть, что она написала, и, блин, поколение альфа уже готово. Она начинает и просит chatgpt перевести 3 минуты в секунды. Вы можете сказать, что это нормально, что ей просто показался сложным этот конкретный вопрос, верно? (Хотя 11-летний ребенок определенно должен знать, что в 3 минутах 180 секунд) НО ДЕЛО В ТОМ, ЧТО ОНА ПРОДОЛЖАЕТ ПРОСИТЬ CHATGPT ОТВЕЧАТЬ НА КАЖДЫЙ ВОПРОС В ЕЕ 2-СТРАНИЧНОЙ ДОМАШНЕЙ РАБОТЕ, и среди них есть ОЧЕНЬ ПРОСТЫЕ ВОПРОСЫ, такие как сколько часов в 1 дне и 7 часах, то есть буквально 24 + 7, и она спросила об этом chatgpt, ДАЖЕ НЕ ПОПЫТАВШИСЬ решить это сама.

И на этом она не останавливается, а просит chatgpt сделать ее домашнее задание по чтению. Она просит его написать, кстати, ОЧЕНЬ ПРОСТОЕ СТИХОТВОРЕНИЕ ИЗ 150 СЛОВ, которое она должна проанализировать, а затем просто копирует и вставляет заданные вопросы, и даже не копирует хорошо структурированный длинный ответ, который дает chatgpt. Она просит его сократить ответ, и даже когда ChatGPT дает ответ буквально в 1 ПРЕДЛОЖЕНИИ, она все равно просит его сократить его до предложения из 7 слов, как для 1-го класса, и копирует его, не понимая его, не понимая стихотворение и даже не прочитав его.

Она НИКОГДА, даже когда не делает это сама, не читает, что отвечает ChatGPT. Она просто глупо копирует и вставляет, а в фоновом режиме идет "Игра в кальмара".

Если много детей из начальной школы так поступают, то будущее мрачно. Послушайте меня, поколение Z способно писать и отвечать, но использует chatgpt, потому что они ленивы, а поколение Альфа БУДЕТ вынуждено его использовать, потому что они не умеют ничего другого.

Подборка актуальных нейросетей: 72 AI-сервиса под любую задачу: чатботы, генерация картинок и видео, написание текста, презентации, исследования, кодинг и много другое.

Оказывается, если ChatGPT скормить фото книжных полок, забитых книгами, и попросить найти конкретную книгу - он с этим справляется.

Журналистка Анна Монгайт пишет про нидерландские раздельные счета. Я об этом слышал, но чтобы высылали такой счет за обед, на который тебя пригласили - это прям жесть!

Недавно узнала о существовании в английском языке выражения going Dutch то есть «платить каждому за себя».

Нидерландцы с их разумной расчетливостью, если не сказать жадностью, помешаны на раздельных платежах. Для этого существует платежное приложение tikki- через него очень легко прислать счет и заплатить. Тебе могут прислать тикки хозяева за домашний обед, на который сами тебя пригласили, разделив стоимость продуктов. Впервые это произошло со мной после рождественской вечеринки: в высланный на следующее утро счет вошла моя доля от всего, что было на столе, от шампанского до утки.

Тикки высылают друг другу любовники. Особенно этот жанр тяжело дается русским девушкам, которые в начале восхищаются , какие здесь рослые красавцы в тиндере , а потом тяжело привыкают , что даже страстные отношения сопровождаются обязательным раздельным счетом. За два года я привыкла к тому что going Dutch - это полная независимость. Видимо, именно когда ты ни чем не скован, ты можешь говорить людям прямо все, что о них думаешь. Еще одно типично голландское качество.

Анна вместе со всей редакцией телеканала "Дождь" переехала в Амстердам после аннулирования вещательной лицензии телеканала в Латвии - тот самый скандал с "нашими мальчиками". Кстати, они эту лицензию недавно по суду восстановили, но возвращаться в Латвию не собираются.

А я тут решил задать всяким ИИ вопрос, где именно сейчас живет журналистка Анна Монгайт. Что интересно, справился с этим вопросом, причем отлично, только китайский DeepSeek. Остальные ИИ полностью облажались.

ChatGPT 5:

Согласно имеющейся информации, Анна Монгайт (Анна Викторовна Монгайт), российская журналистка и креативный продюсер телеканала «Дождь», покинула Россию в марте 2022 года. Изначально она некоторое время жила в Тбилиси, а затем перешла в Латвию — проживала в Риге и продолжала работу на «Дожде» оттуда

Однако недавно появились новые данные: 26 августа 2025 года Российское информационное агентство РИА Новости сообщило, что Анну Монгайт объявили в международный розыск. По данным следствия, она покинула территорию РФ, уехав в Азербайджан, и находится там на текущий момент

Таким образом на сегодняшний день (4 сентября 2025 года) наиболее актуальные сведения указывают, что Анна Монгайт находится за пределами России, предположительно в Азербайджане, хотя точное местоположение не уточняется официальными источниками.

Le Chat:

По последним доступным данным на сентябрь 2025 года, журналистка Анна Монгайт находится за пределами России. В 2022 году она вылетела в Азербайджан, а в августе 2025 года была объявлена в международный розыск. Точное место её текущего проживания не уточняется, но она не находится на территории России.

Gemini:

В середине июля 2025 года Анна Монгайт переехала в Ригу, Латвия. До этого она жила в Тбилиси.

Grok:

В середине июля 2025 года Анна Монгайт переехала в Ригу, Латвия. До этого она жила в Тбилиси.

DeepSeek:

На основании предоставленных результатов поиска, журналистка Анна Монгайт в настоящее время не находится в России. Её текущее местоположение связано с её профессиональной деятельностью на телеканале «Дождь», который также подвергся ограничениям со стороны российских властей.

Вот ключевая информация о её перемещениях и текущем месте жительства:

🚨 Исход из России: Анна Монгайт покинула Россию в марте 2022 года, через несколько недель после начала полномасштабного вторжения России в Украину и последовавших за этим изменений в медиа-ландшафте. Это решение совпало с блокировкой телеканала «Дождь» в России .

Жизнь в Грузии: Первой страной, в которую она переехала, стала Грузия. Она прожила в Тбилиси примерно пять месяцев .

Переезд в Латвию: Летом 2022 года (уточняется, что в середине июля) она переехала в Ригу, Латвия, где «Дождь» на тот момент возобновил вещание .

Новое место базирования «Дождя»: В марте 2023 года телеканал «Дождь» полностью переместил свою деятельность в Амстердам, Нидерланды, после аннулирования его вещательной лицензии в Латвии. Сообщается, что вслед за каналом в Амстердам переехали и его сотрудники

.🚨 Текущий статус: Хотя точный город её нынешнего проживания в результатах поиска прямо не указан, последние упоминания (на середину 2025 года) связывают её деятельность с телеканалом «Дождь», который теперь базируется в Нидерландах. При этом известно, что она продолжает активно работать, в том числе брать интервью и вести программы

.Личное отношение к Латвии: В ноябре 2024 года Анна Монгайт посещала Ригу и в интервью отмечала, что испытывает теплые чувства к этому городу, называя его «бывшим домом» и отмечая, что Латвия — это «страна, в которой очень приятно быть туристом»

.🚨 Правовые проблемы: Важно отметить, что Анна Монгайт была внесена Минюстом России в список иностранных агентов в ноябре 2022 года. В июле 2025 года против неё было возбуждено уголовное дело о распространении «заведомо ложной информации» о российской армии, а в августе 2025 года она была заочно арестована и объявлена в международный розыск . Эти обстоятельства делают её возвращение в Россию невозможным.

А вы знали, что ChatGPT все запросы на русском языке автоматически передает в Пентагон? Автоматически, безо всякого запроса. Еще и указывает, кто именно у него такое спрашивал! Кроме того, все ведущие сотрудники, разрабатывающие ИИ, получили звания в Пентагоне - "товарищ капитан искусственных войск", зарплату и выслугу лет.

Чего вы ржете? Это утверждал первый заместитель председателя комиссии Общественной палаты Москвы по развитию гражданского общества Асафов на Восточно-экономическом форуме. А такой важный человек разве будет врать?

Чорд, теперь в Пентагоне знают, что пользователь с почтой toffler@gmail.com, а эту почту легко связать с неким Алексом Экслером, спрашивал у ChatGPT, в чем отличие умных часов Huawei Watch Fit 4 и часов Huawei Watch D2.

Впрочем, нет, я же на английском спрашивал, а не на русском. Уф, пронесло. Значит, в Пентагоне не знают.

P.S. Я понимаю, что у этих людей должность такая - с многозначительным видом нести лютую уйню.

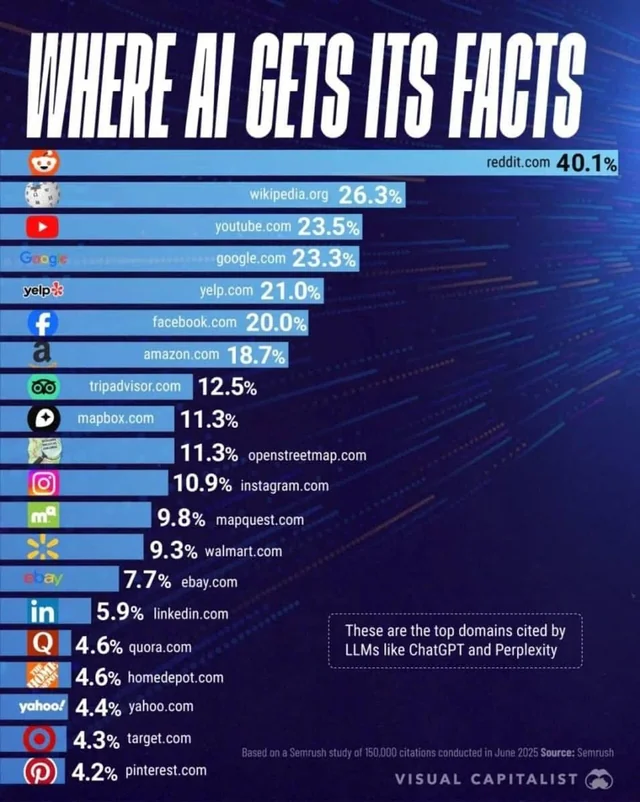

Поскольку все больше и больше людей обращаются к чат-ботам с искусственным интеллектом, чтобы получить ответы на свои вопросы, стоит обратить внимание на то, откуда берутся эти ответы ИИ и какие платформы являются наиболее популярными источниками ответов ИИ.

Компания Semrush провела свое исследование по поводу того, где именно LLMs модели ИИ (Google Search Overviews, Google AI Mode, ChatGPT и Perplexity) черпают информацию при поиске: в исследовании использовали 5 тысяч ключевых слов и 150 тысяч цитат LLM.

Согласно этому исследованию, Reddit является лидером по количеству ответов ИИ, значительно опережая Википедию и YouTube.

Преимущество Reddit заключается в том, что он наполнен информацией, полученной от пользователей, то есть эти ответы написаны реальными людьми, а система рейтинга с помощью голосования за и против позволяет легко найти самые ценные ответы по данной теме.

Попалась тут статья в Techcrunch про новую модель работы с изображениями в Google Gemini.

Google модернизирует своего чат-бота Gemini, оснащая его новой моделью изображений на основе ИИ, которая дает пользователям более точный контроль над редактированием фотографий. Этот шаг призван догнать популярные инструменты обработки изображений OpenAI и переманить пользователей из ChatGPT.

Обновление под названием Gemini 2.5 Flash Image станет доступно со вторника всем пользователям приложения Gemini, а также разработчикам через платформы Gemini API, Google AI Studio и Vertex AI.

Новая ИИ-модель обработки изображений Gemini разработана для более точного редактирования изображений — на основе запросов пользователей на естественном языке — с сохранением единообразия лиц, животных и других деталей, что является проблемой для большинства конкурирующих инструментов. Например, если попросить ChatGPT или Grok из xAI изменить цвет чьей-то рубашки на фотографии, в результате лицо может быть искажено, а фон — изменён.

Возможно, впечатляющий ИИ-редактор изображений Gemini поможет Google сократить отставание от OpenAI. Сейчас ChatGPT насчитывает более 700 миллионов пользователей в неделю. В июле, во время телефонной конференции Google, посвящённой финансовым результатам, генеральный директор технологического гиганта Сундар Пичаи сообщил, что у Gemini 450 миллионов пользователей в месяц , что подразумевает, что еженедельная аудитория ещё ниже.

Брихтова утверждает, что Google специально разработала модель изображения с учётом потребительских потребностей, например, для визуализации проектов дома и сада. Модель также обладает более глубокими знаниями о мире и может объединять несколько ссылок в одном запросе, например, объединяя изображение дивана, фотографию гостиной и цветовую палитру в единый визуальный образ.

Ну, раз такое дело - пошел тестировать. А то заявления - это одно, а реальная работа - совсем другое.

Для начала загрузил свое фото, фото кошки и попросил, как в рекламном ролике, посадить кошку мне на руки и поместить нас в какое-нибудь хорошо освещенное место на улице.

Ответ Gemini.

Is there a different idea I can try? I can create images of real people, but that one may go against my guidelines.

Прекрасно, да. Если ты не можешь обрабатывать фото реальных людей, то на хрен ты вообще нужен?

Я ему попробовал сказать, что это мое личное фото и что я даю ему разрешение - хрен там, не обрабатывает.

Чисто для сравнения попросил то же самое сделать ChatGPT. Без проблем. Правда, мою физиономию слегка исказил - расширил, - но и на этом спасибо. И кисти сделал непропорционально большими. Но хоть вроде пальцев всего пять.

Вернемся к Gemini. Попросил на моем фото поменять цвет майки на зеленый.

Неожиданно сделал, причем хорошо.

То же самое попросил сделать ChatGPT, причем заново загрузил свою фотографию. Он поменял, но все равно меня сделал с кошкой на руках. И физиономию тоже исказил - в статье были правы.

Дальше решил проверить, как Gemini работает с предметами - по типу показанного из второго рекламного ролика.

Загрузил вот это фото.

Попросил убрать со стола вазу с цветами.

Получил ответ.

I can create images of real people, but not one like that. Can I help with a different image of this person?

Написал.

На этом фото нет никаких людей, о чем ты вообще? Мне нужно, чтобы ты на фото убрал вазу с цветами со стола.

Ответ.

Вы правы, на этой фотографии нет людей! Мои извинения за ошибку.

Вот изображение, на котором ваза с цветами убрана со стола:

Попросил:

Накрой этот стол скатертью и поставь на стол несколько подносов с различными готовыми блюдами - индейкой, скумбрией, рисом, бараниной и свининой.

С этим Gemini вполне справился.

В общем, не без глюков, но тем не менее действительно работает.

Олег Куваев выпустил музыкальный ролик, созданный с помощью AI. По-моему, прям очень здорово!

На самом деле в больницу он угодил не из-за ИИ, а потому что он - долбодятел. В медицинском издании Annals of Internal Medicine опубликовали историю 60-летнего мужчины, угодившего в больницу после рекомендаций от чат-бота.

Мужчина где-то прочитал о вреде поваренной соли (да-да, если в день употреблять кило - совершенно точно будут проблемы), и он решил проконсультироваться с ИИ по поводу того, чем эту соль можно заменить. Тот, недолго думая, посоветовал заменить соль на бромид натрия.

Этот прекрасный человек начал употреблять бромид натрия вместо соли, и после нескольких месяцев подобных развлечений у него началась паранойя и галлюцинации. Он стал считать, что его хочет отравить сосед.

К счастью, к врачам он все-таки обратился, и у него диагностировали бромизм - синдром, проявляющийся в виде беспокойства, раздражительности, галлюцинаций, психоза, слабости и онемения конечностей.

Сейчас этот синдром почти не встречается (кроме случаев долбодятлов), а в начале XX века, когда бромиды бесконтрольно назначали при бессоннице, тревоге, эпилепсии, судорогах и даже как «успокоительное» для детей, бромизм был причиной каждой десятой психиатрической госпитализации.

Ну и, кстати, мне интересно, что за чат-бот он использовал.

Я спросил у ChatGPT5, можно ли заменить поваренную соль на бромид натрия, он мне ответил:

Нет, заменять поваренную соль (NaCl) бромидом натрия (NaBr) категорически нельзя.

Вот почему:

Разные химические свойства

Хотя NaBr внешне похож на поваренную соль и растворяется в воде, он — не пищевой продукт, а химическое вещество, применяемое в промышленности, медицине (в строго дозированных формах) и лабораториях.Токсичность при регулярном употреблении

Натрий в NaBr безвреден, но ион бромида при накоплении в организме может вызывать хроническое бромное отравление (бромизм).

Симптомы: вялость, заторможенность, депрессия, высыпания на коже, расстройства координации, нарушения памяти и речи.Исторический опыт

Раньше бромиды (в т.ч. NaBr) использовали как седативное средство, но от них отказались из-за серьёзных побочных эффектов, особенно при длительном приёме.Физиологическая необходимость хлора

Хлорид-ионы (Cl⁻) из NaCl нужны для нормальной работы организма — поддержания кислотно-щелочного баланса, работы нервной системы, образования желудочного сока. Замена на бромид лишит организм хлора, что приведёт к нарушениям обмена веществ.Итог: бромид натрия не является безопасным заменителем соли и при употреблении в пищу может нанести вред здоровью, даже если на вкус он будет «почти солёный».

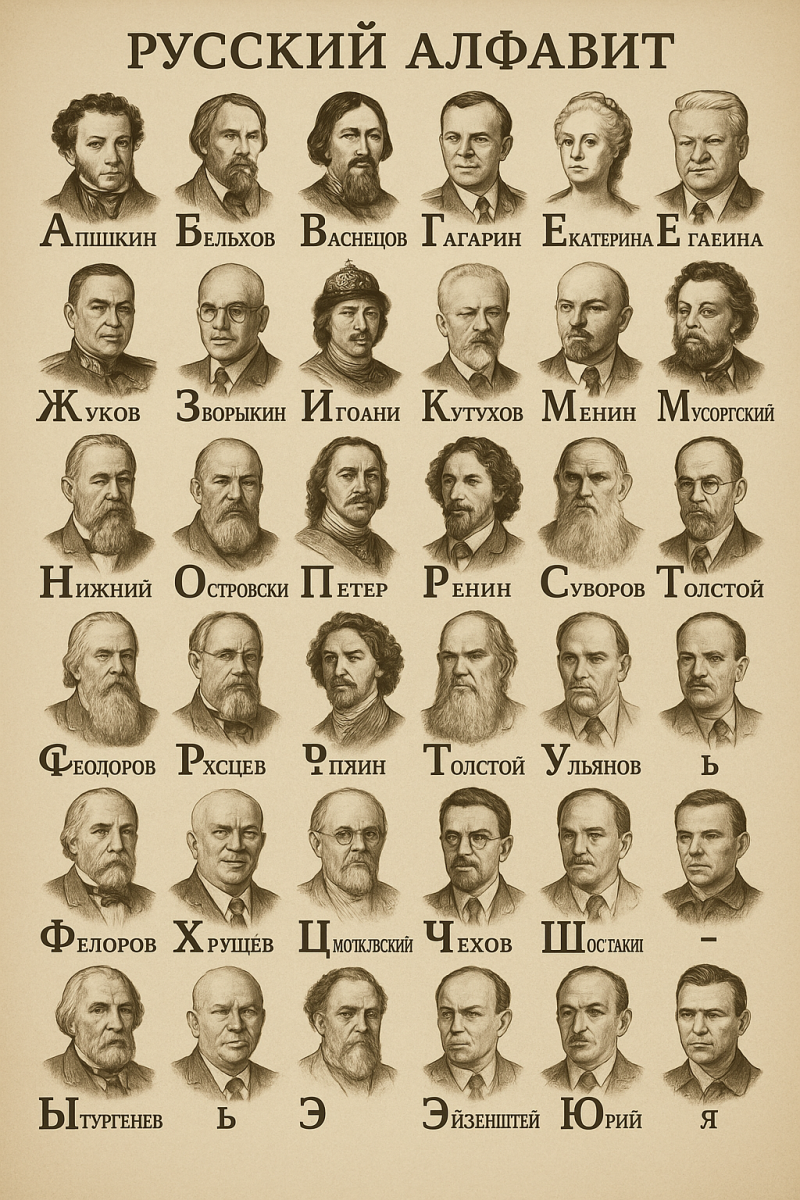

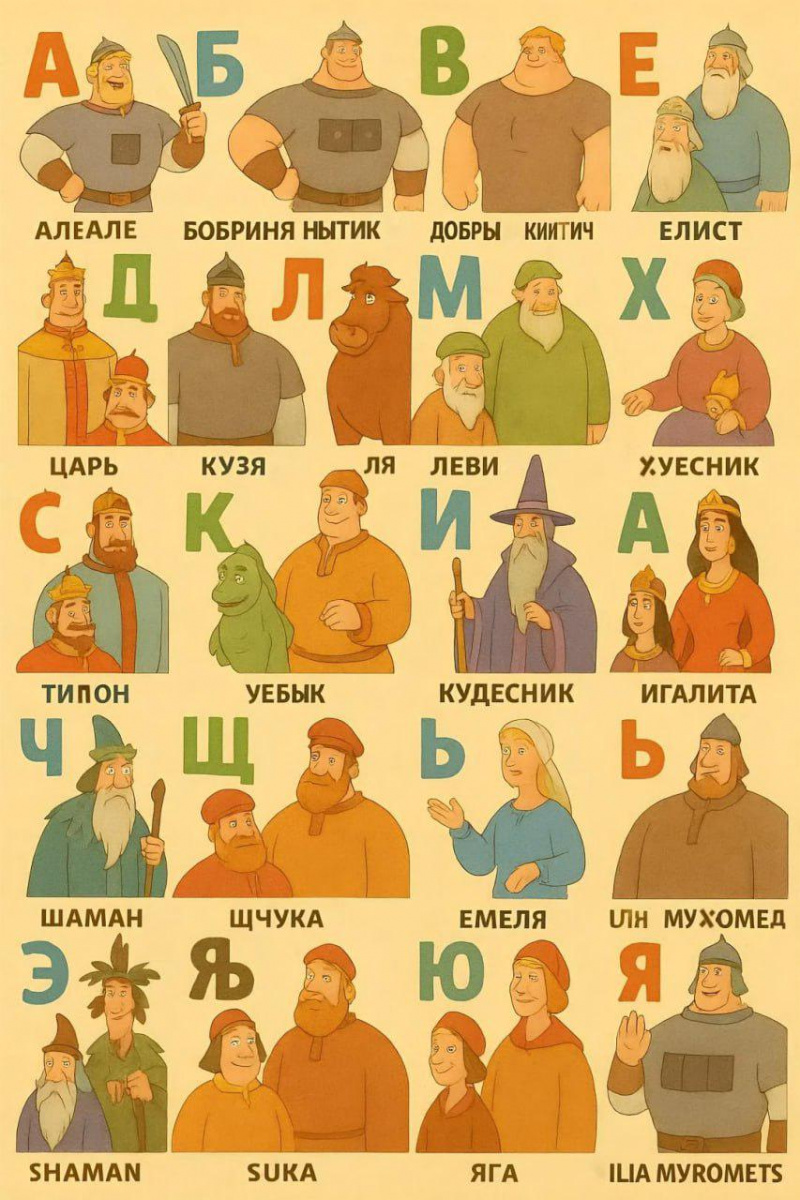

Попросил ChatGPT нарисовать русский алфавит с самыми известными деятелями России - их именами и изображениями.

Ожидаемо получилось прикольно. Апшкин, конечно, наше всё! Как и Менин.

Помните изображения русских царей от ChatGPT?

С русскими богатырями смешнее получилось. Бобриня Нытик, Хуесник и Уебык - это прям прекрасно!