ChatGPT Search

Компания OpenAI представила ChatGPT Search. Утверждают, что, цитирую:

Теперь ChatGPT может осуществлять поиск в Интернете гораздо лучше, чем раньше. Вы можете получать быстрые и своевременные ответы со ссылками на соответствующие веб-источники, для получения которых раньше нужно было обращаться к поисковой системе. Таким образом, преимущества естественного языкового интерфейса сочетаются с ценностью актуальных спортивных результатов, новостей, котировок акций и многого другого.

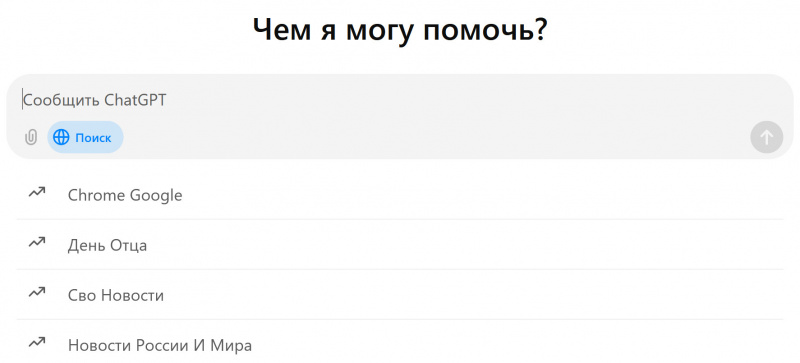

ChatGPT сам выберет поиск в Интернете, основываясь на вашем вопросе, или вы можете вручную выбрать поиск, нажав на иконку веб-поиска.

У меня ChatGPT платный, поиск этот там появился.

Но я пока, если честно, не понял, чем это отличается от обычного запроса к самому ChatGPT. Ведь в обоих случаях он шерстит разные источники и выдает ответ.

Попробовал сравнить - просил выдать план поездки на юг Испании, как в примере OpenAI - результате примерно одинаковые, только при использовании поиска в ChatGPT еще и дополнительно картинки выдает.

Кто-нибудь эту штуку уже тестировал? Какие впечатления?

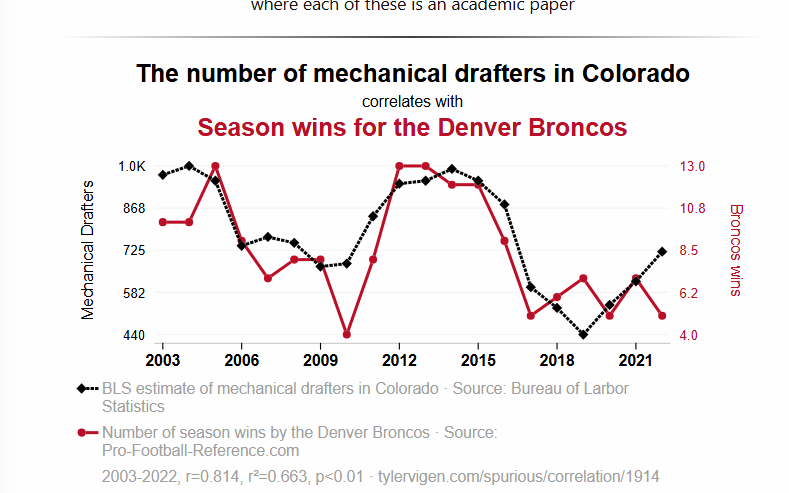

Gemini: The steel walls of the torus should be at least 0.97 meters thick to withstand the rotational forces and maintain structural integrity. Asked to check calculations and came back - the required wall thickness is reduced to 0.34 meters.

Copilot: Based on the calculations, the steel walls should be at least 154.02 meters thick to safely withstand the rotational forces without compromising structural integrity.

GPT4: The required wall thickness for the steel outer walls would be approximately 0.31 mm.

Rotational Stress Requirement: The walls need to handle a hoop stress of approximately 38.5MPa, which is within the capacity of steel, even with minimal thickness.

Pressure Vessel Requirement: To contain the internal atmosphere at 1 atm pressure, the walls should be at least 10 mm thick.

Considering safety factors, manufacturing tolerances, and additional loads (like meteor impacts or thermal stresses), a practical wall thickness would be several centimeters, say 5 cm.

Без указания поперечного сечения тороида невозможно сказать, какова необходимая толщина стенок для удержания внутреннего давления. Можно только сказать, сможет ли сталь выдерживать собственный вес, создаваемый вращением. А ответ на этот вопрос зависит от удельной прочности стали на разрыв, но (в первом приближении) не от ее толщины.

Кстати, если интересно, удельная прочность материала, необходимая для создания обода радиуса R, вращающегося со скоростью, при которой ускорение точек на ободе равно a, равна попросту R*a. Для 0.5 км и 1 g это ~5*10^3 м²/с². Прочность стали (2-7)*10^5.

o1-preview, таким образом, был наиболее близок к истине: важна удельная прочность, а не толщина.

В АI не заложен вариант ответить "Понятия не имею", но может написать типо "Этого я точно не знаю, спроси гугл".

Если такого ещё нет, то скоро будет.

И он не зелёный, а синий.

Подозрительный источник.

За меньше чем полгода успел помимо гугла пройтись по Apple, Microsoft, цукеру, по AI в целом, OpenAI (аж три раза) и персонально по Сэму.

Про AI у него интересные и довольно большие статьи, например - про компанию openai:

www.wheresyoured.at

www.wheresyoured.at

Индусский говнокод - давно уже притча во языцах и мем.

А теперь видно, что как управленцы они проваливаются еще более эпично.

Верните Бена Гомеса на место!

В любом случае, мне это не особо мешает, я сразу нахожу нужные абзацы, навык читать по диагонали

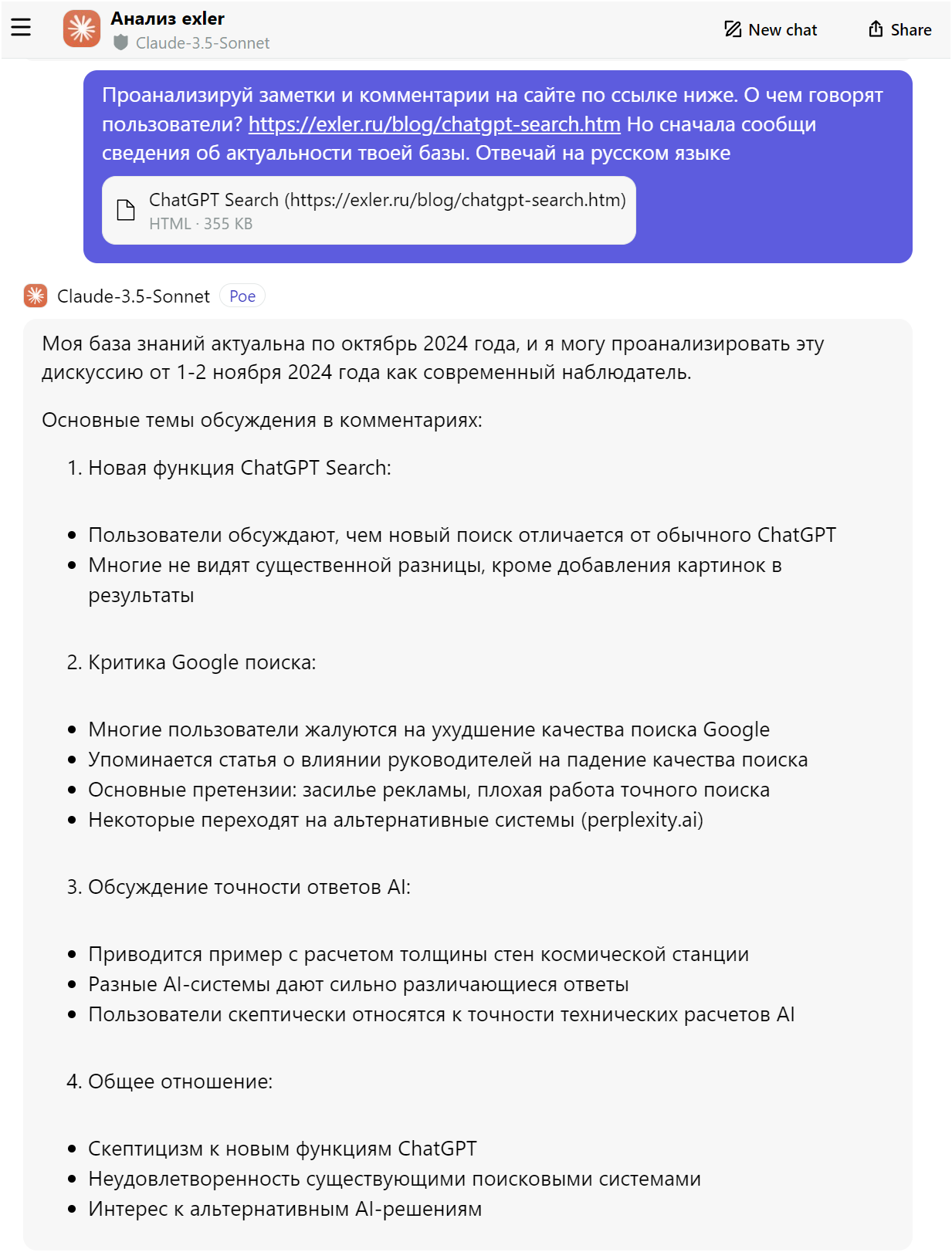

А для резюме можно пользоваться AI:

Резюме статьи "Реквием по Рагхавану"

Статья утверждает, что смещение П. Рагхавана с поста старшего вице-президента по поиску в Google и его назначение на менее влиятельную должность "главного технолога" сигнализирует о серьезных проблемах в компании.

Ключевые тезисы статьи:

Рагхаван был ключевой фигурой в ухудшении качества поиска Google. На основании внутренних документов, обнародованных в ходе антимонопольного разбирательства, автор утверждает, что именно Рагхаван стоял за рядом решений, которые привели к снижению релевантности результатов поиска и увеличению количества рекламных объявлений.

Ухудшение качества поиска Google - серьезная проблема. Автор выражает обеспокоенность тем, что снижение качества поиска может негативно повлиять на пользователей и весь интернет.

Вывод:

Статья представляет собой критический анализ ситуации в Google и указывает на то, что компания переживает серьезные внутренние проблемы. Автор считает, что смещение Рагхавана - это симптом более глубоких проблем, которые могут привести к дальнейшему ухудшению качества услуг Google.

И поисковики не влияют на происходящее

Я уже молчу о том, что гуглопоиск на русском в Швейцарии абсолютно ватный.

Теперь понятно, что его поломали 2 индуса в угоду рекламе и монетизации, вот настоящие скоты-корпораты.

Теперь понятно, что его поломали 2 индуса в угоду рекламе и монетизации, вот настоящие скоты-корпораты.

Теоретически обычный ЧатГПТ "не знает", что случилось совсем недавно. То есть если спросить, что было вчера, то он может отослать к Гуглу - у меня такое было.

не знаю, как он в качестве поисковика, но он задуман с другой целью )

Одна деталь, что-то зарегистрироваться в нем стало проблемно. Во всяком случае я не смог, так что пробовал Клод только у друга - впечатлил.

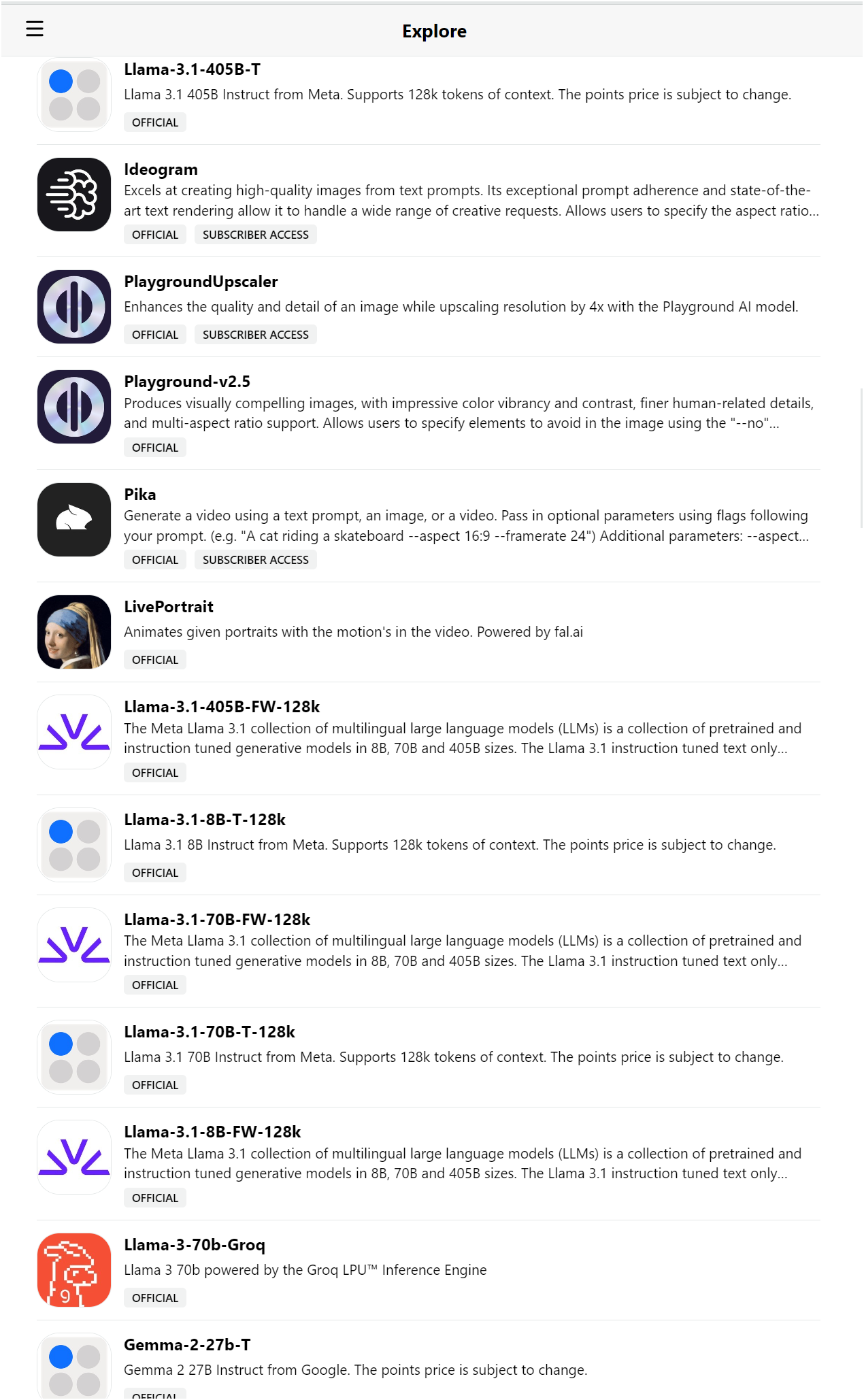

Хотя этих АИ сейчас уже столько - не уследишь.

Он для совместной и соло работы. То что я пробовал - помощь в написании/придумывании историй и ходов. Это лучше чем у ЧатаГПТ. Там много возможностей, времени протестировать не было (

Вот тут о нем подробнее - www.anthropic.com

Хотя с картинками тоже умеет, но я не пробовал. Картинки - не мое. Я не художник, я с текстами работаю.

Для переводов со сложных языков кроет всех, как бык овцу (при правильно составленном промпте). Перевод 1 авторского листа занимает секунды, редактура требуется минимальная (на уровне 0-2 слова на страницу).

В общем, нужно тестировать, но я вот только сегодня прорвался через регистрацию и застрял на знакомстве. Падает все время (

Имхо - Клод сегодня лучший из текстовых нейронок

В общем Cloude сейчас топ, а ChatGPT по качеству в догоняющих.

И если вы говорите, что у него база до 15 октября, то неплохо бы уточнение на бесплатном ли это тарифе или платном.

Вот прямо сейчас искал самый тонкий однокамерный стеклопакет, уже и желаемую толщину указывал и поисковики менял и языки...

С другой стороны, Гуглом стало почти невозможно пользоваться так что уже почти без разницы какой системой искать.

Хотя на мой взгляд Гугл все же лучшее что сейчас есть, но он действительно стал вводить чрезмерные ограничения

Лидер чемпионата, Макс Ферстаппен из «Ред Булл», финишировал шестым, получив два штрафа по 10 секунд за инциденты в борьбе с Норрисом.

После этой гонки Ферстаппен продолжает лидировать в общем зачете с 362 очками, Норрис занимает второе место с 315 очками, а Леклер — третье с 291 очком.

Следующий этап чемпионата пройдет в Бразилии с 1 по 3 ноября.

----

Это правильный ответ?

Это не поиск, это какая то сводка плюс картинки и ссылки на источники. Гугл поиск и чатгпт - это разные услуги.

Первый запрос в Гугл выдал ссылку на Википедию где было написано раза в 3 больше, плюс ссылки на Youtube.

Вот только что попробовал - работает. Единственное что русский не с ходу опознал, т.е. приветствие на русском, что то типа рад поработать и бла бла бла, а потом переключился на инглиш, со второго раза - дал вводный урок, начал давать, не стал слушать дальше.

Не может он этого делать - авторские права, видимо, насколько я понимаю.

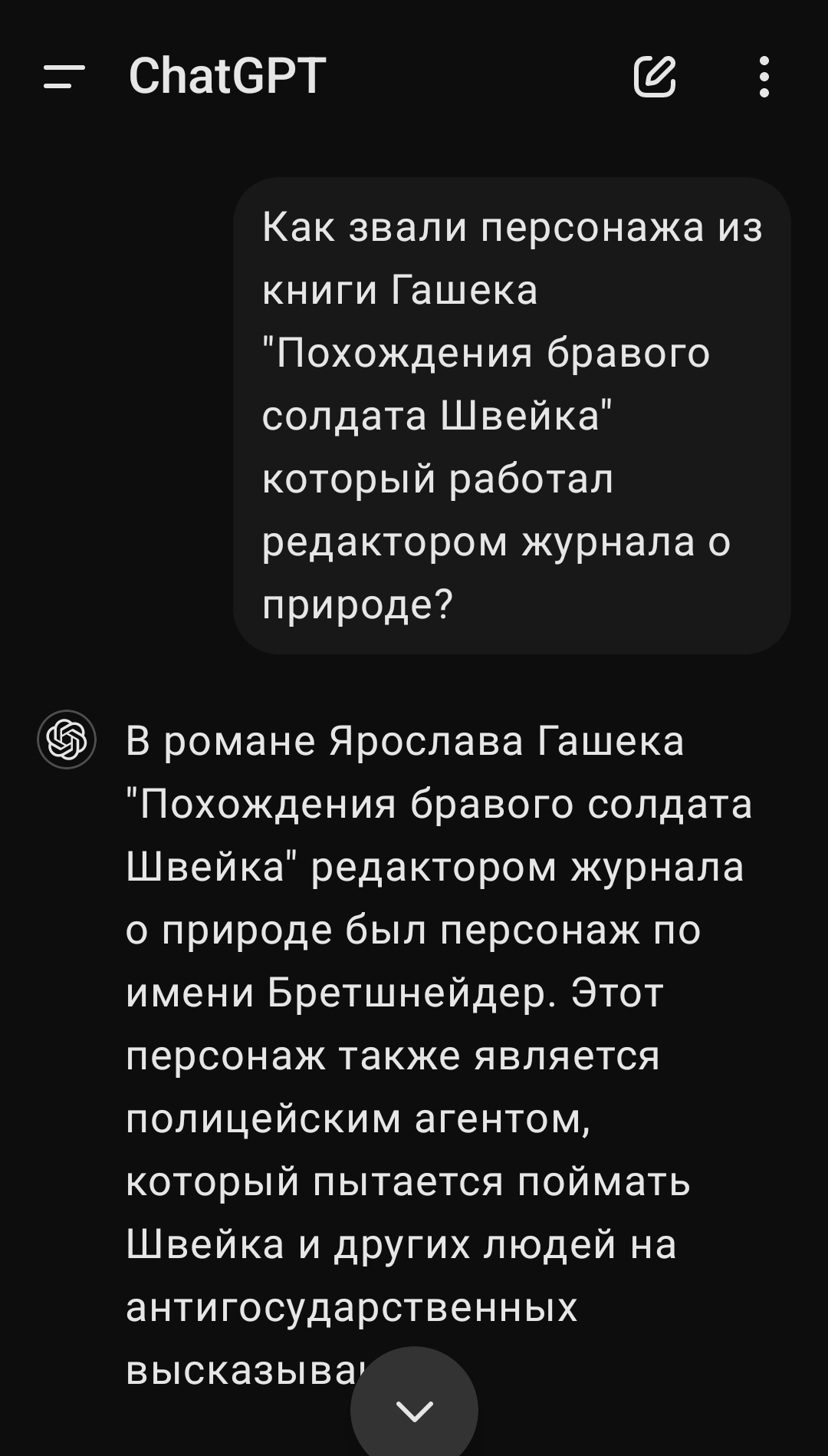

И будет изворачиваться, ответить нужно обязательно.

но это серьезное предупреждение и риски для гугла.

Рекомендуются просьбы вида "напиши подводящее объяснение, только ПОТОМ ответ" (потому что если эта падла первым шагом напишет неверный ответ, дальше она будет пытаться объяснить, почему он всё-таки верный), "предоставь ссылки на релевантные материалы" и прочий prompt engineering.

Для себя пока что сделал вывод что чатГПТ хорош когда надо быстро получить какой-то микс несерьёзных данных- например сделать лошадь с головой кита, набросать поездку на 7 дней из Барселоны или узнать какие были модели PlayStation.

А если что-то для меня минимально серьёзное и особенно с числами, типа какой диаметр болта с резьбой М10, то я на этого вруна не полагаюсь, ну его нафиг.

Это источник оценок по неизвестным тебе эвристикам (пример: мне понадобилось узнать число автомобилей в Саратове - эта штука дала ссылку на новость с числами по всей области и свою оценку числа именно для города). Можно пытаться сказать "напиши мне эвристики", но в общем случае выведенный текст правил и реально использованные правила могут не пересекаться.

Это источник примерного описания базовых понятий какой-то области (пример: выяснение того как в Python выглядят аннотации типов для функторов и перечислений) - быстрый способ получить относительно короткий текст по делу. Предел применимости: в сколько-нибудь специфичных областях оно начинает врать, это вопросы про именно начальный уровень. (У меня, кажется, было ровно ноль программистских вопросов, по которым я бы сходу не нашёл ничего поисковиком, затем спросил у ChatGPT, и ответ бы помог мне решить проблему.)

Это способ быстро в одно лицо проверить написанный текст на косяки - "укажи в тексте ниже места, которые выглядят неоднозначно или вызывают замешательство".

То есть, в основном эта штука даёт ответы задним числом очевидные, но есть довольно много ситуаций когда очевидные комментарии всё ещё полезны.

Зачем же он тогда выдаёт точные ответы (которые ими не являются), если не он не источник точных ответов?

GPT обучена сначала определять распределение вероятностей для следующего слова в тексте, а затем не назначать высоких вероятностей цепочкам слов, которые вызывают негативную оценку тестировщиков (т.н. RLHF).

Как оказалось, если окружить ввод пользователя некоторым системным текстом и продолжить его с помощью такой системы, то при тексте пользователя сформулированном как вопрос, продолжение выглядит для человеческого глаза похожим на ответ.

Потом оказалось что это можно продать.

Потом выяснились некоторые детали того, почему ответы выглядят так как выглядят (исследователями в области "interpretability", попыток переложения подлежащего перемножения огромных матриц на язык более человеческих абстракций).

По пути люди делали разной смелости заявления о том, насколько мы теперь ближе к AGI, "общему" искусственному интеллекту. Некоторые люди из этого множества входили в число обнаруживших что это можно продать.

Насколько эти заявления верны? Хрен его знает, если коротко. Изначально такой кросс-доменной эффективности языковых моделей никто не ожидал, так что мы определённо наткнулись на что-то для нас новое. Но с пониманием того, а что именно делает процессы в наших черепах - "разумом", у нас до сих пор очень плохо. И с уверенностью сказать, что конкретно трансформеры и механизм внимания - это 1% оставшегося пути, или 40% оставшегося пути, или 95% оставшегося пути, мы просто не можем.

Так и сейчас с ИИ. Мне (и не только мне) тут недавно некоторые доказывали что дескать мы в шаге о создания полностью разумного ИИ, несмотря на факты о том что этот ИИ сейчас не может понять элементарное и просто тупо врёт. И до разумности ему как до звезды пешком.

Наверняка скоро будет всё больше тех кто, как и я, не видит обещаемого по сравнению с реальностью. И будет появляться всё больше таких разъяснений как написали вы, что дескать чего вы хотите, вообще-то всё это эвристика да и всё.

Ща посыплется похожее. У Мешка на телефоне Perplexity тем же занимается...

И таки да, получив ссылку на фишкинет ты можешь оценить качество результата "поиска". В отличие от просто простыни текста.